OpenAI revela GPT-4o, modelo de IA generativa que analisa vídeos em tempo real

A OpenAI revelou, nesta segunda-feira (13), o lançamento do novo modelo de linguagem GPT-4o. A evolução do sistema que dá vida ao ChatGPT agora funciona com mais habilidades de compreensão de texto, imagens e voz.

Uma das grandes novidades da plataforma é a capacidade de analisar vídeos em tempo real. Ou seja, um usuário pode abrir a câmera do celular, por exemplo, e ir mostrando um problema de matemática para que a IA confira se as contas estão sendo feitas corretamente.

Nesta interação, a pessoa poderá até mesmo abrir a câmera de selfie do celular e perguntar ao chatbot questões sobre a roupa que está vestindo. Em outro exemplo, também será possível ligar a câmera de selfie para que o ChatGPT seja o juiz de uma partida de jokenpô. Confira, abaixo, o vídeo:

O GPT-4o ainda recebeu melhorias no formato de interação por voz. Com isso, a ferramenta irá transformar o ChatGPT em uma espécie de evolução da Alexa, da Amazon.

Com uma interação bem parecida com a humana, o novo modelo de linguagem promete respostas de até 232 milisegundos, muito parecido com a resposta de um ser humano numa conversa real. Isso faz com que a IA generativa funcione como um assistente virtual que pode conversar, cantar, contar histórias, explicar e mais.

Tudo isso será feito com diferentes tons de voz. Ou seja, o usuário poderá até pedir para que o ChatGPT explique algo com uma voz mais melancólica, alegre, raivosa, em um estilo mais robótico etc.

Mais avanços trazidos pelo GPT-4o

Segundo a OpenAI, a letra “o” de GPT-4o significa “omni”, já que ele mistura voz, vídeo, texto e imagem. A ideia é justamente pontuar que a plataforma base base do ChatGPT integra tudo em uma coisa só.

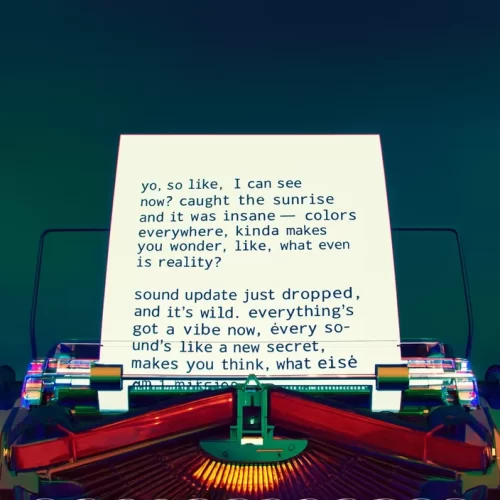

Na apresentação desta terça-feira, a OpenAI explicou que o GPT-4o também pode apresentar textos em formatos de livro ou uma escrita numa máquina de escrever. Neste caso, o usuário poderá pedir um texto e o ChatGPT retornará não no formato tradicional, mas com o texto escrito dentro de uma imagem especial. Confira, abaixo, o exemplo:

Além disso, a tecnologia promete melhorias na análise de imagens. Ou seja, os usuários poderão realizar uploads de fotos e detalhes de cada imagem poderão ser analisadas pela IA.

Outra capacidade promovida pelo GPT-4o será a tradução em tempo real. Nestas situações, duas pessoas poderão se encontrar e o sistema de IA poderá ir traduzindo a fala de um para o outro, para que ambos possam se entender na conversa.

Disponibilidade do GPT-4o

Os recursos de texto e imagens do GPT-4o foram lançados hoje no ChatGPT, só que somente para usuários Plus. Uma nova versão do Modo de Voz com GPT-4o chegará em alfa no ChatGPT Plus nas próximas semanas.

Já para os desenvolvedores, o GPT-4o chegará em formato de API como um modelo de texto e visão em breve. Segundo a OpenAI, o GPT-4o é duas vezes mais rápido, custa metade do preço e tem limites de taxa mais altos em comparação com o GPT-4 Turbo.

fonte: tecmundo